1 Transformer介绍¶

学习目标¶

- 了解Transformer背景

1.1 Transformer的诞生¶

2017年,Google发出一篇论文《Attention is All You Need》,提出了transformer模型。它彻底改变了自然语言处理 (NLP) 领域,并在机器翻译、文本生成、文本分类等任务中取得了显著的成果。

2018年10月,Google发出一篇论文《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》, BERT模型横空出世, 并横扫NLP领域11项任务的最佳成绩!

论文地址: https://arxiv.org/pdf/1810.04805.pdf

而在BERT中发挥重要作用的结构就是Transformer, 之后又相继出现XLNET,roBERT等模型击败了BERT,但是他们的核心没有变,仍然是Transformer。

1.2 什么是Transformer¶

Transformer是一种基于自注意力机制(Self-Attention)的序列到序列 (sequence-to-sequence) 的深度学习模型,最早由Vaswani等人在2017年的论文《Attention is All You Need》中提出。旨在解决自然语言处理(NLP)中的序列到序列(Seq2Seq)问题,如机器翻译等任务。

与传统的循环神经网络(RNN)和长短期记忆网络(LSTM)不同,Transformer完全依赖于自注意力机制,并摒弃了序列化计算过程,允许模型并行处理整个输入序列,因此具有更高的效率和更强的性能。

核心思想:注意力机制是Transformer模型的核心。它可以让模型在处理序列中的每个位置时,关注序列中其他位置的信息。 这意味着模型可以根据当前任务动态地调整每个位置的重要性,从而更好地捕捉序列中的长距离依赖关系。

1.3 Transformer的优势¶

相比之前占领市场的LSTM和GRU模型,Transformer有两个显著的优势:

- 并行计算:与RNN和LSTM不同,Transformer在编码器端使用自注意力机制,而不是递归神经网络,不需要逐步处理序列中的每个元素,因此可以通过并行计算大幅度加速训练过程。Transformer能够利用分布式GPU进行并行训练,提升模型训练效率。

- 捕捉长距离依赖:自注意力机制能够直接计算输入序列中任意两个元素之间的关系,从而更好地捕捉长距离依赖。在分析预测更长的文本时, 捕捉间隔较长的语义关联效果更好。

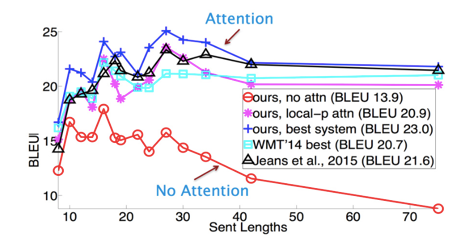

下面是一张在测评比较图:

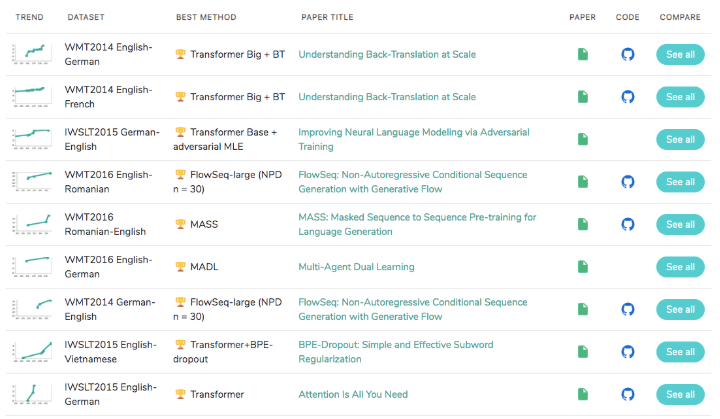

1.4 Transformer的市场¶

在著名的SOTA机器翻译榜单上, 几乎所有排名靠前的模型都使用Transformer。

Transformer基本上可以看作是工业界的风向标, 市场空间自然不必多说!

1.5 小结¶

-

transformer诞生:

- 2017年,Google发出一篇论文《Attention is All You Need》,提出了transformer模型。

- 2018年10月,Google发出一篇论文《BERT》,BERT中发挥重要作用的结构就是Transformer。

-

什么是transformer:

- Transformer是一种基于自注意力机制(Self-Attention)的序列到序列 (sequence-to-sequence) 的深度学习模型。

- Transformer 完全依赖于自注意力机制,允许模型并行处理整个输入序列,具有更高的效率和更强的性能。

- transformer优势:

- 基于自注意力机制,在编码器端可以并行处理输入序列,大幅度加速训练过程。

- 基于自注意力机制,能够直接计算输入序列中任意两个元素之间的关系,从而更好地捕捉长距离依赖。